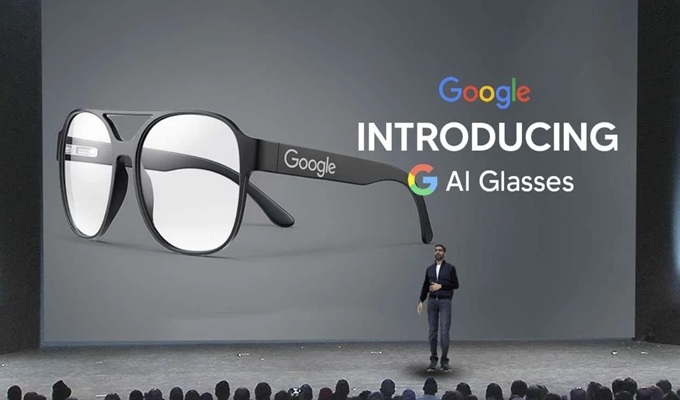

Les lunettes IA de Google, AI glasses dopées par l’IA de Gemini, grande nouveauté attendue en 2026

Les lunettes IA de Google, des AI glasses dopées par l’IA de Gemini, attendues pour 2026, marquent le véritable retour de la marque sur le marché des smart glasses avec deux modèles pensés pour une aide contextuelle continue, pilotée par Gemini et Android XR.

Elles se distinguent à la fois des anciens Google Glass et des lunettes Meta actuelles par une approche centrée sur l’assistant IA multimodal et une intégration profonde à l’écosystème Android/XR, avec des usages du quotidien moins “gadget” et plus utilitaires.

Lunettes IA Google : ce qui arrive en 2026

Google a confirmé travailler sur deux paires de lunettes IA, conçues avec Samsung, Gentle Monster et Warby Parker, qui doivent arriver sur le marché “l’année prochaine”, soit en 2026.

Ces lunettes s’inscrivent dans la stratégie Android XR, la plateforme pensée pour les appareils de “réalité étendue” (casques, lunettes filaires et lunettes IA) et déjà utilisée sur le casque Samsung Galaxy XR.

La première paire, décrite comme des “AI glasses”, est orientée assistance vocale sans écran, avec haut‑parleurs, micros et caméra intégrés pour dialoguer naturellement avec Gemini, prendre des photos et obtenir des réponses contextuelles.

La seconde, appelée “display AI glasses”, ajoute un affichage dans les verres pour afficher discrètement des informations comme la navigation, les sous‑titres de traduction ou d’autres contenus utiles dans le champ de vision.

Spécificités face aux anciens Google Glass

Contrairement aux Google Glass de première génération, pensées surtout comme un mini écran tête haute pour notifications et captures vidéo, les nouvelles lunettes IA se construisent autour de Gemini et de Project Astra, des assistants capables d'”entendre” et de “voir” le même contexte que l’utilisateur.

Là où les Glass souffraient d’une IA limitée et de problèmes de coût et d’acceptation sociale, Google explique avoir tiré les leçons de ces erreurs pour proposer des produits plus discrets, mieux intégrés à la chaîne de fabrication et au design optique, grâce à ses partenaires lunetiers.

Technologiquement, l’évolution clé est l’IA multimodale : Gemini/Project Astra peuvent analyser en temps réel l’environnement, mémoriser ce que l’utilisateur a vu et fournir une aide proactive (ex. retrouver un objet aperçu plus tôt, guider un bricolage pas à pas, contextualiser un trajet).

Les lunettes deviennent ainsi une interface permanente avec l’assistant plutôt qu’un simple écran déporté, ce qui repositionne complètement le rôle des smart glasses dans l’écosystème Google.

Face aux lunettes Meta : atouts et différences

Les Ray‑Ban Meta ont déjà trouvé leur public avec une combinaison de caméra, commandes vocales, affichage dans la monture et intégration profonde à l’IA de Meta, avec des usages comme la traduction en temps réel, le partage vidéo, la navigation et les appels.

Meta a d’ailleurs pris une longueur d’avance commerciale avec plusieurs millions d’unités vendues et un écosystème optique robuste via son partenariat avec EssilorLuxottica.

Google mise cependant sur plusieurs atouts distinctifs :

– Une intégration native à Android XR et aux services Google (Maps, YouTube, Messages, etc.), offrant continuité entre smartphone, casque XR et lunettes.

– Un assistant universel (Gemini/Project Astra) pensé pour comprendre la scène visuelle, la voix et le contexte, avec des démos montrant par exemple la capacité à se souvenir d’objets vus, à analyser un vélo ou un écran et à suggérer des actions complexes.

– Deux form factors complémentaires (audio‑only et affichage dans les verres), permettant à Google de couvrir à la fois les usages discrets de type “oreillette IA” et ceux d’AR légère pour la productivité et la traduction.

Date de sortie et contexte de lancement

Google indique que “les premières lunettes arriveront l’année prochaine”, dans le cadre de la feuille de route Android XR présentée lors de “The Android Show: XR Edition” début décembre 2025. Les deux types de lunettes sont annoncés pour 2026, même si la marque ne précise pas encore si les modèles audio‑only et à affichage seront lancés simultanément ni sur quels marchés en priorité.

Le lancement s’inscrit dans un contexte de compétition directe avec Meta et d’ouverture de l’écosystème XR de Google : d’un côté, le casque Galaxy XR, de l’autre les lunettes IA et les futures lunettes XR filaires comme Project Aura, destinées à offrir un “canvas” d’applications Android XR dans un format de lunettes plus immersif.

Pour Google, 2026 pourrait ainsi marquer le basculement d’une logique “smartphone + montre” vers un trio “smartphone + XR + lunettes IA”, où les lunettes deviennent la porte d’entrée la plus naturelle vers l’IA au quotidien.

Tekiano avec IA